Le module image vous est proposé par le projet ICAR (image et interaction)

.......

Module Image ....... Le module image vous est proposé par le projet ICAR (image et interaction) |

|

Olivier

Strauss, LIRMM,

département robotique. 04 67 41 85 87.

Olivier

Strauss, LIRMM,

département robotique. 04 67 41 85 87.  William

Puech, LIRMM, département

robotique. 04 67 41 86 85.

William

Puech, LIRMM, département

robotique. 04 67 41 86 85.

|

sur le module image en

envoyant un e-mel (cliquez sur le penseur). |

: Pour vous connecter sur la

page institutionnelle de l'intervenant

: Pour vous connecter sur la

page institutionnelle de l'intervenant  : Pour récupérer une

présentations (lorqu'elles nous a été transmise)

: Pour récupérer une

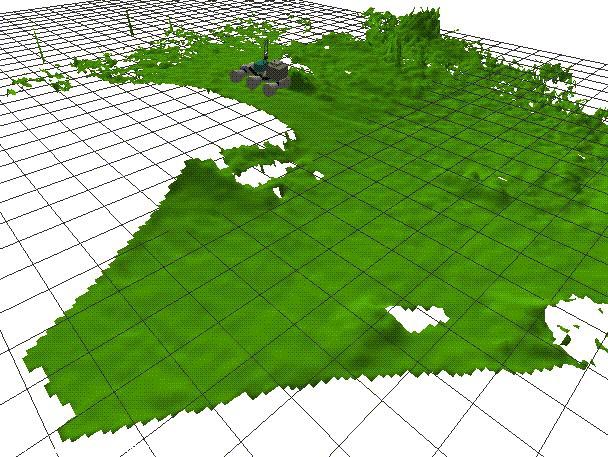

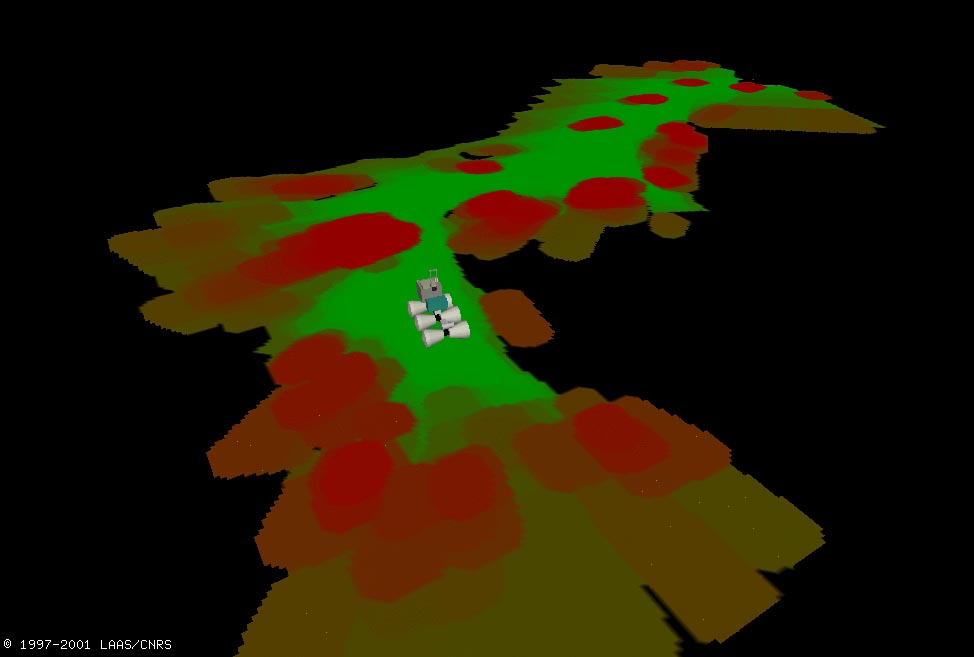

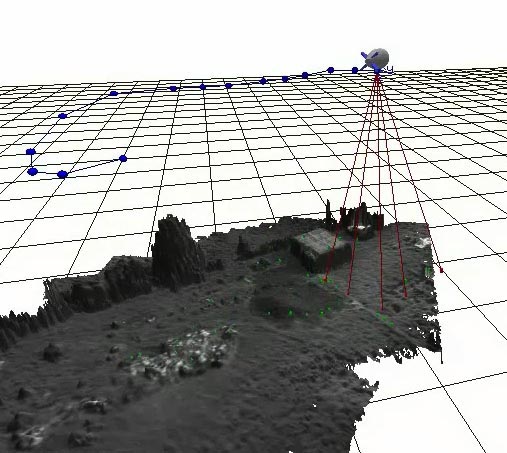

présentations (lorqu'elles nous a été transmise)  Jeudi 31

janvier 14h00 : Modélisation de l’environnement par vision en

robotique mobile.

Jeudi 31

janvier 14h00 : Modélisation de l’environnement par vision en

robotique mobile. Simon Lacroix - LAAS,

Toulouse - Simon.Lacroix@laas.fr

Simon Lacroix - LAAS,

Toulouse - Simon.Lacroix@laas.fr

| Pour réaliser de

manière autonome des tâches de déplacement,

d’exploration ou de surveillance, un robot mobile doit disposer de

représentations de l’environnement dans lequel il évolue.

Ces représentations sont de natures diverses selon le type

d’environnement d’une part (intérieurs de bâtiments,

environnements extérieurs urbains ou naturels), et selon les

fonctions qui les exploitent d’autre part (principalement localisation,

planification de trajectoires ou d’itinéraires, contrôle

d’exécution des déplacements). Pour construire ses représentations, les robots son dotés de nombreux capteurs (odomètres, capteurs inertiels, télémetrie, ultrasons...), et en particulier de caméras, selon différentes modalités : vision monoculaire, stéréovision ou vision panoramique. Des traitements de base permettent d’acquérir des images 3D denses par stéréovision, ou d’extraire des points d’intérêt depuis une image en monoculaire ou panoramique, puis de mettre en correspondance ces points entre deux images acquises depuis des positions différentes du robot. L’exposé présentera comment ces techniques sont exploitées pour construire les représentations de l’environnement nécessaires à l’autonomie du robot. En particulier, il insistera sur le lien intime entre modélisation de l’environnement et localisation au sein de cet environnement, et présentera en détail le problème dit de “Localisation et Cartographie Simultanées” (SLAM en anglais). Il sera illustré par des résultats obtenus dans différents contextes, pour des robots terrestres et aériens. |

|

|

|

Jeudi 14

février 14h00

: Stéréovision et mise en correspondance : applications

en télédétection aérienne et satellitaire.

Jeudi 14

février 14h00

: Stéréovision et mise en correspondance : applications

en télédétection aérienne et satellitaire. Marc Pierrot Deseilligny - Maison

de la téledetection, Montpellier - pierrot@teledetection.fr

Marc Pierrot Deseilligny - Maison

de la téledetection, Montpellier - pierrot@teledetection.fr

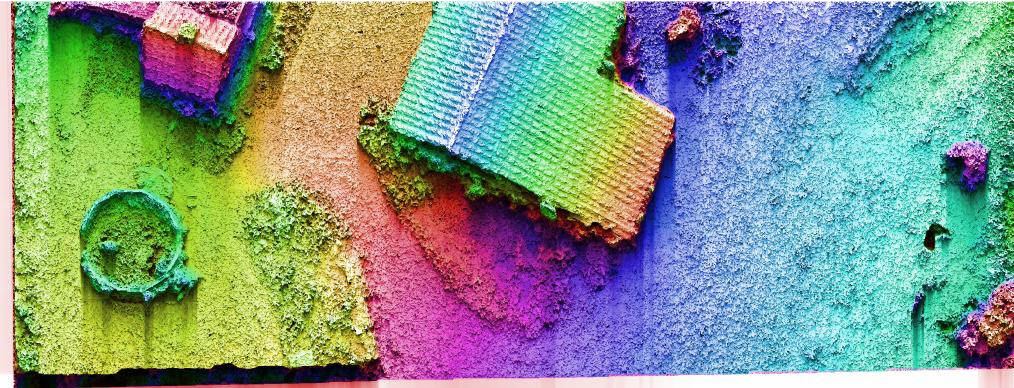

multi-stéréoscopie

sur zone ubaine

|

couple spot 5 en zone rurale

|

image de façade urbaine |

Jeudi 13 mars 14h00 : Image et couleur

:

Jeudi 13 mars 14h00 : Image et couleur

:  Alain

Trémeau - LIGIV, Saint-Etienne - tremeau@ligiv.org

Alain

Trémeau - LIGIV, Saint-Etienne - tremeau@ligiv.org

| Le domaine de l’image couleurs

constitue, à part entière, un secteur de recherche et

développement d’une très grande complexité. En

effet, au-delà de la question « quelles sont les

données qui contribuent fondamentalement à définir

une image couleurs ? » ou de la question « comment se

répercute sur l’image la modification de l’une de ces

données ? », se pose également le problème

de la subjectivité de l’observation visuelle. Pour comprendre comment une image s’est formée (sources d’éclairement, optique, capteur), il est nécessaire de faire appel à la physique. Il en est de même pour comprendre comment certaines interactions lumineuses (phénomènes d’ombrage, de réflexion colorée, de transparence, de constance des couleurs) entre objets ont pu modifier l’image. |

|

|

Pour comprendre comment une

image est perçue par un observateur (adaptation chromatique,

contrastes simultanés, apparence couleur, focus d’attention), il

est nécessaire de faire appel à la psychophysique. De

même, pour comprendre comment certains phénomènes

visuels peuvent modifier la perception que l’on a d’une scène,

il est nécessaire de s’intéresser au Système

Visuel Humain (SVH). |

| Pour analyser comment l’image

est constituée (niveau pixel, niveau spatiofréquentiel,

niveau objet, niveau sémantique), il est nécessaire de

faire appel à toute une chaîne d’opérateurs de

traitement d’images (filtrage, segmentation, indexation) qui

eux-mêmes relèvent notamment de la modélisation

mathématique (représentation scalaire ou vectorielle des

données, espaces de représentation couleur). De

même, pour analyser la qualité d’une image (image fixe ou

vidéo, image couleur ou multispectrale), il est

nécessaire de sélectionner (analyse discriminante,

réseau de neurones, apprentissage) parmi tous les descripteurs

image (netteté, contraste, diversité des couleurs) ceux

qui satisfont au mieux au problème posé. Pour prédire comment l’image sera restituée sur un périphérique donné (écran CRT, LCD, HDR, imprimante multiprimaires) il est nécessaire de caractériser au préalable ce périphérique (management des couleurs, domaine des couleurs restituables) en faisant appel notamment à l’électronique et au traitement du signal (numérisation, codage des données, compression, transmission). D’une manière générale, l’image couleurs requiert donc un ensemble de connaissances et de compétences extrêmement large et diversifié. L’objectif de l’exposé sera d’illustrer ces notions à travers différents exemples. |

|

Jeudi 3 avril 14h00 : Synthèse

d'images et animations: application

à la sculpture virtuelle et à la représentation 3D

de terrains.

Jeudi 3 avril 14h00 : Synthèse

d'images et animations: application

à la sculpture virtuelle et à la représentation 3D

de terrains.  Gilles

Gesquière - LSIS, Marseille - gilles.gesquiere@up.univ-mrs.fr

Gilles

Gesquière - LSIS, Marseille - gilles.gesquiere@up.univ-mrs.fr

|

L’image virtuelle est

présente autour de nous dans des domaines comme l’audiovisuelle,

les maquettes virtuelles ou les mondes virtuels temps

réels. L’image est dans la plupart des cas animée et cela

si possible en obtenant une grande interactivité utilisateur

–programme. Dans ce cours, nous reprenons dans un premier temps le processus de construction d’images fixes ou animées à partir de scènes comportant des objets 3D. Nous montrerons ensuite à l’aide de deux exemples les compromis nécessaire entre obtention d’un résultat temps réel et images réalistes (proches du monde réel). |

Jeudi 15

mai 14h00 : Mise en correspondance des images d’une séquence

vidéo avec un modèle :

Jeudi 15

mai 14h00 : Mise en correspondance des images d’une séquence

vidéo avec un modèle :  Jean

Sequeira - LSIS, Marseille - Jean.Sequeira@univmed.fr

Jean

Sequeira - LSIS, Marseille - Jean.Sequeira@univmed.fr

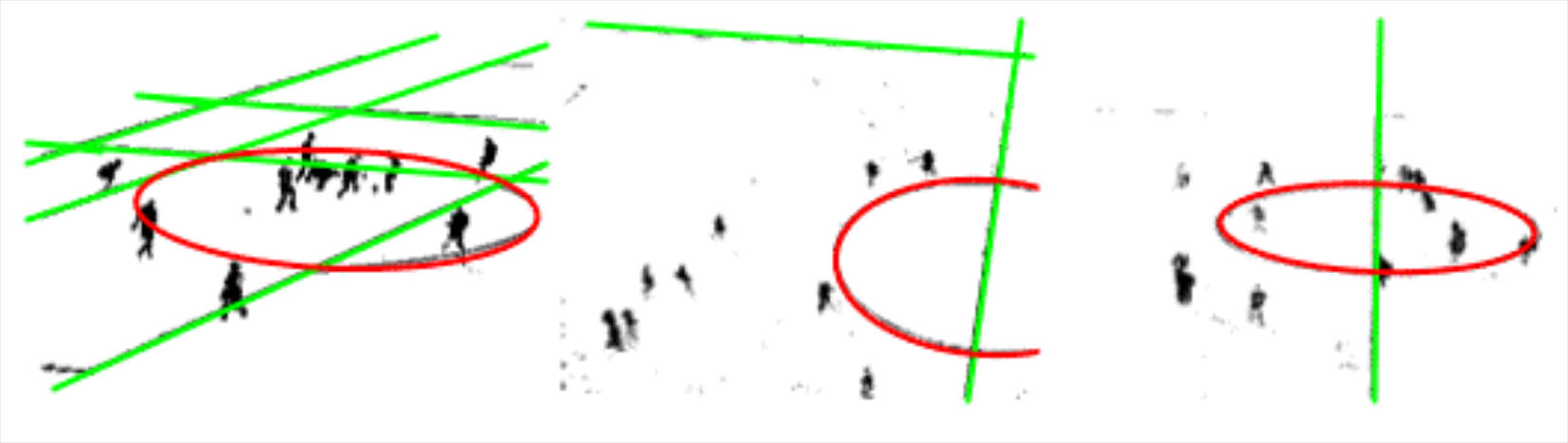

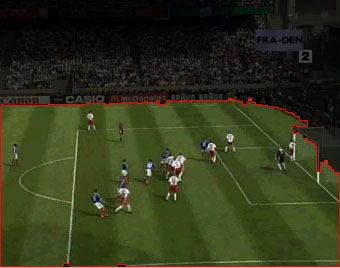

Reconstitution d’un modèle 3D à partir d’une image vidéo et visualisation depuis un autre point de vue |

Cette présentation

traitera de la mise en correspondance d’images avec un modèle

dans le cas où la scène associée dispose de

certaines caractéristiques bien spécifiques. Dans

l’application que nous aborderons par la suite, la scène – ou

tout au moins la partie qui nous intéresse – s’organise à

partir d’un espace 2D, ce qui nous amènera à chercher une

correspondance 2D-2D. Les images ci-dessous illustrent cette

application : nous disposons de séquences vidéo de

matches de football et nous cherchons reconstituer un modèle 3D

qui représente ces séquences (il s’agira en fait d’un

modèle 2D dans lequel seront disposés des

éléments 3D) – ici nous en resterons à une

reconstitution statique à partir d’une seule image. Deux questions fondamentales se posent pour résoudre ce problème :

La détection d’amers (dans la « Région d’Intérêt ») s’appuiera, pour la caractérisation de droites et d’ellipses, sur des algorithmes originaux relatifs à la Transformation de Hough, et que nous décrirons ici en détail. Enfin, nous montrerons comment il est alors possible de mettre en correspondance l’image et le modèle, et nous illustrerons notre propos par l’application associée au projet Simulfoot. Ci-dessous : exemple de détection d’amers   |

|

|

| Détection

de la région d’intérêt |

|

Jeudi 29mai 14h00 : Introduction

à la biométrie & reconnaissance de visage

:

Jeudi 29mai 14h00 : Introduction

à la biométrie & reconnaissance de visage

:  Jean-Luc

Dugelay - Institut EURECOM, Sophia Antipolis - Jean-Luc.Dugelay@eurecom.fr

Jean-Luc

Dugelay - Institut EURECOM, Sophia Antipolis - Jean-Luc.Dugelay@eurecom.fr